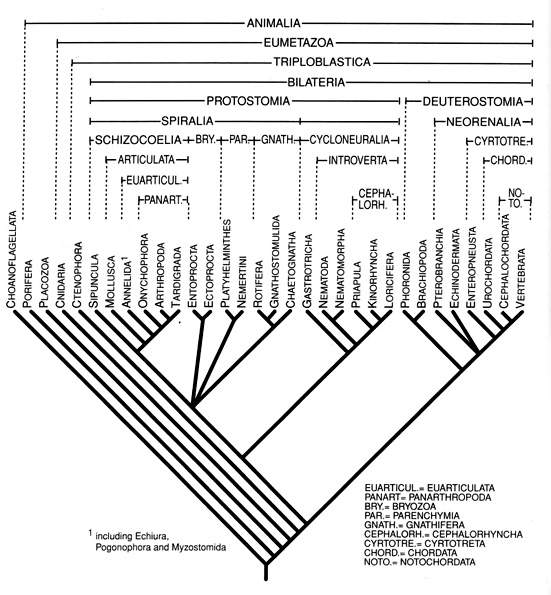

[tav. 1]

La filogenesi degli animali (Metazoa): l'albero del regno "Metazoa".

Riprodotto da Claus Nielsen, Animal Evolution. Interrelationships of the living phyla,

2nd edition, New York, Oxford University Press, 2001.

di Manuel Barbera (b.manuel@inrete.it).

Il linguaggio umano, ormai ci è ben evidente, è un sistema

estremamente complesso; come tale deve appoggiarsi a strutture specializzate

per poterlo gestire. Alcune di queste strutture sono propriamente fisiologiche,

come l'apparato fonatorio (che esamineremo perlando della fonetica), l'apparato auditivo,

il cervello ed il sistema nervoso, altre più propriamente mentali come la memoria.

Dire "mentali", nell'accezione più intuitiva, vale 'dotate senz'altro di un sostrato

fisiologico, ma ad esso non intieramente riducibili': in realtà l'opposizione tra

mente e cervello o (come più spesso si dice, essendo la moderna filosofia della mente

prevalentemente di area anglofona) mind - brain è uno dei problemi più

dibattuti nella filosofia moderna: proprio intorno a questo problema si è sviluppata la cosiddetta

Cognitive science

e molta parte della moderna filosofia analitica. Cosa, in effetti, possa o debba più

precisamente intendersi per "mentale" è un problema complesso quanto affascinante,

che non possiamo certo approfondire adeguatamente qui. Ci basti ricordare che tutta la tradizione

linguistica che si richiama a Saussure e tutta la tradizione filosofica che si rifà

a Brentano ed alla sua nozione di "intenzionalità" sostengono la radicale alterità

degli stati mentali (cfr. la "inesistenza intenzionale") dagli stati di cose (fisicità e natura);

una consistente parte dei moderni filosofi della mente (tra cui Chomsky) ne sostengono

invece la riducibilità agli stati naturali, ossia la loro "naturalizzazione".

Da un lato, pertanto, si accentua l'opposizione mente - cervello, e dall'altra si

cerca di ridurre il più possibile la mente al cervello.

Le strutture per gestire il linguaggio (assumendo che una distinzione

tra l'ordine del mentale e l'ordine del fisiologico di fatto ci sia, la si spieghi

poi come si vuole) va poi sottolineato che sono frutto dell'evoluzione alla pari di

tutti gli altri organi degli esseri viventi.

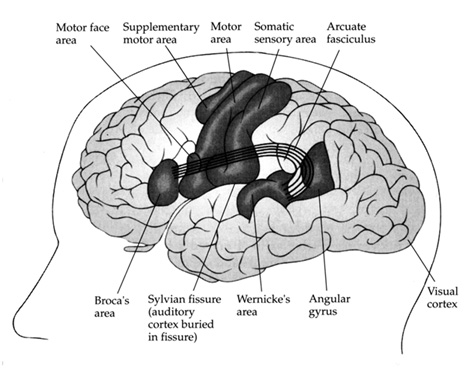

Un "sistema nervoso" (che comprende le strutture associate al linguaggio), ad esempio, è

stato sviluppato solo negli animali ("[Metazoa"), ma un sistema centralizzato anziché

una mera rete di gangli nervosi è innovazione di un solo gruppo di animali, i "Cordata",

al cui sottogruppo "Vertebrata" appartengono i principali animali superiori (pesci, rettili, uccelli,

anfibi, mammiferi), e pertanto anche l'uomo.

Per rendersi conto della "singolarità" evolutiva dei vertebrati rispetto agli altri

animali considerate la tavola seguente:

[tav. 1]

La filogenesi degli animali (Metazoa): l'albero del regno "Metazoa".

Riprodotto da Claus Nielsen, Animal Evolution. Interrelationships of the living phyla,

2nd edition, New York, Oxford University Press, 2001.

Intuitivamente, tutti sappiamo cosa è la memoria, e consideriamo

il linguaggio come qualcosa di strettamente legato (nel senso la langue è

qualcosa che deve essere "ricordato" dall'individuo). In generale,

la memoria, le sue strutture fisiologiche ed il suo funzionamento, sono

stati studiati molto approfonditamente, tanto da psicologi e linguisti quanto da

neurologi e medici, sicché possiamo dire di averne una discreta conoscenza.

Il primo dato interessante è che anche la memoria sembra una struttura frutto

dell'evoluzione naturale. Tutti i mammiferi, ad esempio, uomo compreso sembrano

condividere la stessa impostazione di funzionamento:

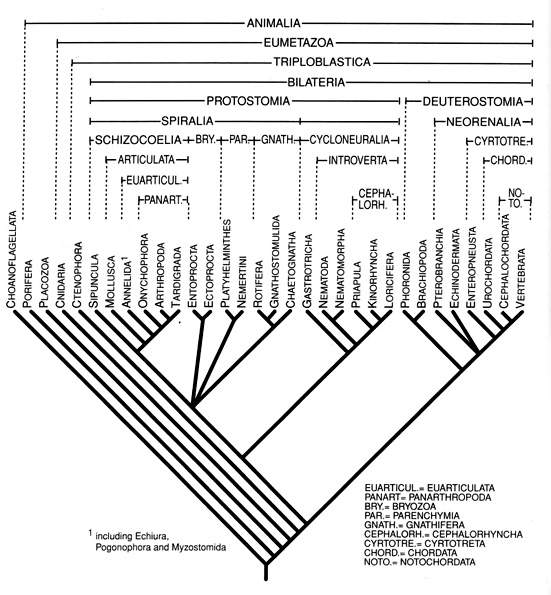

[tav. 2]

Il funzionamento della memoria nei mammiferi: riprodotto da Richard F. Thompson,

The brain. A Neuroscience Primer, 3rd edition, New York, Worth Publishers,

2000, p. 354.

L'informazione sensoriale entra in un "registro sensoriale" ("memoria iconica")

dove è mantenuto per un tempo brevissimo (nell'ordine dei decimi di secondo: la dimostrazione

risale a G. Sperling nel 1960). Alcune di queste informazioni sono scartate,

altre invece sono trasferite nella "memoria operativa a breve termine" (nell'ordine

delle decine di secondi), parte delle quali è poi salvata, in genere dopo essere stata

adeguatamente esercitata, nella memoria a lungo termine (di durata teoricamente illimitata),

mentre un altra parte viene definitivamente persa (alcune informazioni

visive, inoltre, possono passare direttamente dal registro sensoriale alla memoria a

lungo termine). Seguendo la via contraria, invece, le informazioni sono recuperate

dalla memoria profonda, trasferite nella memoria operativa, e poste in esecuzione.

Particolarmente interessante è che la memoria operativa sembra coincidere con la consapevolezza e con quello che chiamiamo di solito "coscienza", mentre la memoria a lungo termine ha più le caratteristiche dell' "inconscio" (è cioè un gigantesco serbatoio di conoscenze delle quali non siamo propriamente consapevoli, ma alle quali attingiamo al bisogno riportandole nella memoria operativa a breve termine). La concezione della memoria a breve termine come "coscienza", frequente in neuroscienza, converge anche nella nozione di intenzionalità, così come la avevamo definita, e rende linguisticamente assai interessante il problema della Animal Consciousness: la tradizione filosofica (Cartesio) e la religione (cattolicesimo) occidentali negavano infatti agli animi una "coscienza"!

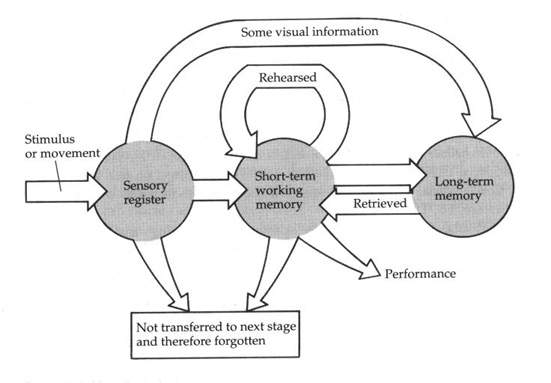

Quanto al linguaggio (la "langue") dovrebbe, ragionevolmente, essere depositato nella memoria a lungo termine. In realtà, dobbiamo ormai specificare ulteriormente il nostro discorso: quando si parla di "memoria" intendiamo, in effetti, molte strutture diverse, solo con alcune delle quali il linguaggio ha relazioni:

[tav. 3]

I principali tipi di memoria a lungo termine: riprodotto da Richard F. Thompson,

The brain. A Neuroscience Primer, 3rd edition, New York, Worth Publishers,

2000, p. 365. All'interno della memoria non dichiarativa od implicita vi sono vari

sottotipi, tra cui i principali sono il riflesso incondizionato ed il priming;

di quella dichiarativa od esplicita i sottotipi principali (non rappresentati nella tavola)

sono la memoria procedurale od episodica (è relativa al "come"), e quella semantica (relativa al "cosa").

Il linguaggio, nello schema precedente, è posto nella memoria dichiarativa, più precisamente in quel suo sottotipo che è la "conoscenza semantica" (in base alla quale, ad es., uno ricorda il significato delle parole o le tabelline aritmetiche, ma non "quando" le ha imparate) - l'altro sottotipo è la "memoria episodica" (in base alla quale, ad es., uno ricorda cosa ha mangiato a pranzo, o chi ha incontrato il giorno prima, ecc.).

Un dato interessante dello schema precedente è che le principali

strutture "mentali" (tipi di memoria) sono messe in relazione alle strutture materiali

(aree del cervello). Un ruolo centrale, in particolare, sembra giocato dall' "ippocampo",

nel lobo medio temporale (ne sono presenti due, uno nel lato destro ed uno nel lato sinistro):

è infatti famoso nella letteratura medica il caso di HM, un paziente che dovette subire la

rimozione di entrambi gli ippocampi sviluppando una amnesia anterograda (vive esclusivamente

nel presente, in tutto normale se non nella impossibilità di immagazzinare nuove

informazioni ed esperienze nella memoria a lungo termine).

Analoghe esperienze cliniche hanno però insegnato che le aree del cervello coinvolte

dall'attività linguistica sono soprattutto altre, nell'adulto di solito attive

nel solo emisfero sinistro, anche se questa "lateralizzazione" non è assoluta: nel bambino

entrambi gli emisferi sono coinvolti, e solo gradualmente si specializza il sinistro;

noi stessi, entro certi limiti, riusciamo ad attivare le diverse aree:

[tav. 4]

Un popolare test per rendersi conto di quale emisfero del cervello uno stia correntemente

usando: normalmente l'emisfero sinistro presiede alle attività logiche e linguistiche,

laddove il destro alla visione, all'immaginazione ed alle sensazioni in genere.

Se si vede la ballerina ruotare in senso orario, si sta usando prevalentemente l'emisfero destro;

se in senso antiorario il sinistro. Con un po' di attenzione (tipo guardando altrove, ad es.

leggendo questo testo, e lasciando la ballerina alla sola coda dell'occhio)

si può cambiare l'attività cerebrale, e vedere la ballerina cambiare improvvisamente senso di rotazione.

Il test è diffuso in molte fonti sul web; io l'ho tratto da una pagina del

DailyTelegraph.

Le zone del cervello coinvolte dall'uso del linguaggio sono

essenzialmente due: l'area di Broca (così chiamata perché scoperta nel 1861 dal

neurologo, antropologo e chirurgo francese Paul Pierre Broca, 1824 – 1880) e l'area

di Wernicke (così chiamata perché scoperta dallo psichiatra, neurologo e medico

slesiano Carl Wernicke, 1848-1905):

[tav. 5]

Le principali strutture fisiologiche (emisfero sinistro) del cervello coinvolte nell'attività

linguistica: riprodotto da Richard F. Thompson,

The brain. A Neuroscience Primer, 3rd edition, New York, Worth Publishers,

2000, p. 442.

Sample 1

What brought you to hospital?

Yes . . . ah . . . Monday . . . ah . . . Dad . . . Peter Hogan, and Dad . . .

ah . . . hospital . . . and ah . . .Wednesday . . . Wednesday nine o’clock and ah

Thursday . . . ten o’clock ah doctors . . . two . . . two . . . an doctors and . . .

ah . . . teeth . . . yah . . . And a doctor an girl . . . and gums, an I.

Sample 2

Describe your job.

Lower Falls . . . Maine . . . Paper. Four hundred tons a day! and ah . . . sulphur

machines, and ah . . . wood . . . Two weeks and eight hours. Eight hours . . .

no! Twelve hours, fifteen hours . . . workin . . . workin . . . workin! Yes, and

ah . . . sulphur and . . . Ah wood. Ah . . . handlin! And ah sick, four years ago.

Sample 3

Telling about a recent movie:

Odessa! A swindler! down there . . . to study . . . the sea . . . (gesture of

diving) . . . into . . . a diver! Armenia . . . a ship . . . went . . . oh! Batum!

a girl . . . ah! Policeman . . . ah . . . I know! . . . cashier . . . money . . . ah!

cigarettes . . . I know . . . this guy . . .

[tav. 6]

Tre esempi di tipica afasia di Broca da John C. L. Ingram, Neurolinguistics.

An Introduction to Spoken Language Processing and its Disorders, Cambridge - New York

- Melbourne - Madrid - Cape Town - Singapore - São Paulo, Cambridge University Press,

2007, p. 49.

Sample 1

What brings you to hospital?

Boy, I’m sweating, I’m awful nervous, you know, once in a while I get caught

up, I can’t mention the tarripoi, a month ago, quite a little, I’ve done a lot

well, I impose a lot, while, on the other hand, you know what I mean, I have

to run around, look it over, trebbin and all that sort of stuff.

Sample 2

Thank you Mr X. I want to ask you a few –

Oh sure, go ahead, any old think you want. If I could I would. Oh, I’m taking

the word the wrong way to say, all of the barbers here whenever they stop

you its going around and around, if you know what I mean, that is tying and

tying for repucer, repuceration, well, we were trying the best that we could

while another time it was with the beds over there the same thing . . .

[tav. 7]

Due esempi di tipica afasia di Wernicke da John C. L. Ingram, Neurolinguistics.

An Introduction to Spoken Language Processing and its Disorders, Cambridge - New York

- Melbourne - Madrid - Cape Town - Singapore - São Paulo, Cambridge University Press,

2007, pp. 49-50.

Questo, almeno, è il quadro classico; in realtà, la recente introduzione

della tecnica della risonanza magnetica (fMRI), finalmemnte un modo non invasivo

per vedere cosa effettivamente succeda nel cervello sganciandosi dalle sole osservazioni (negative)

delle lesioni cerebrali patologiche o traumatiche, ha reso possibile una vera rivoluzione

di conoscenza. In particolare, dei recenti (la notizia è del giugno 2003:

Mariacristina Musso - Andrea Moro - Volkmar Glauche - Michel Rijntjes - Jürgen Reichenbach -

Christian Büchel - Cornelius Weiller, Broca’s area and the language instinct,

in "Nature Neuroscience" 6 (2003)7, pp. 774-81) studi svolti da Andrea Moro,

un linguista attualmente all'Università San Raffaele di Milano, rivendicano un

ruolo ancora più importante all'area di Broca, che è risultata coinvolta nell'uso

delle regole effettive della lingua, ma non in quelle "finte" inventate dai ricercatori:

ruolo che la candiderebbe (dal punto di visto chomskyano) a principale sede del

linguaggio. Cioè sarebbe la sede delle operazioni della sintassi, e pertanto

un perfetto candidato all'organo del linguaggio di Chomski, uscendo così dal folklore della

ghiandola pituitaria di Cartesio.

Come riassumono Xiang et alii, con tutta l'esatezza del linguaggio

medico del caso (lo riporto di modo che potete "assaggiarlo"), il quadro nuovo

che emergerebbe sarebbe perlomeno del tipo seguente: «It has been

suggested, based on Broca and Wernicke’s classical

clinical observations and many subsequent studies, that there is

a neural loop that is involved in language processing (Ojemann

1991) located around the lateral sulcus (also known as the fissure

of Sylvius). This is located in the dominant hemisphere (the left for

most people), connected by the arcuate fasciculus. Broca’s area

lies at the rostral end of this loop;Wernicke’s area is situated at the

other end (in the superior posterior temporal lobe). The inferior

parietal lobule, also knownas "Geschwind’s territory" (Catani et al.

2005), has also been implicated in language processing by recent

neuroimaging studies. For example, several diffusion tensor

imaging (DTI) studies showed that the inferior parietal lobule is

connected by large bundles of nerve fibers to both Broca’s area and

Wernicke’s area (Catani et al. 2005; Parker et al. 2005; Powell et al.

2006). Thus, besides the frontal and temporal language areas, the

parietal lobe is now also thought to play an important role in the

perisylvian language networks.

In the perisylvian language networks, Broca’s area is the first

area of the brain to have been associated with language

function (Broca 1861) and is crucial in all classical and newly

developed neurobiological models of language (see review by

Price 2000). For a long time, Broca’s area was taken as 1 single

unit for language processing (Nishitani et al. 2005). However,

its anatomical and functional segregation has recently become

a focus of attention» (Hua-Dong Xiang - Hubert M. Fonteijn - David G. Norris -

Peter Hagoort, Topographical Functional Connectivity Pattern in the Perisylvian Language

Networks, in "Cerebral Cortex" 23(2010)marzo, pp. 549-60.

Un altro interessante punto, oltre a dove viene immagazzinato ed

quali strutture si appoggia il linguaggio, è come viene acquisito - e se

viene acquisito (non è infatti qui in questione l'apprendimento di una lingua

seconda, "L2", quanto la acquisizione della propria madrelingua, "L1", ossia

de "linguaggio" tout court). La letteratura sull'apprendimento del linguaggio

è sterminata, ed i suoi caposaldi sono riportati in tutti i manuali di glottodidattica,

cui possiamo rimandare (da Giovanni Freddi, Psicolinguistica, sociolinguistica,

glottodidattica, Torino, UTET, 1999 a Camilla Bettoni, imparare un'altra lingua,

Bari, Laterza, 2001). A noi, però, in questo momento non interessano tanto gli aspetti

"applicati" quanto quelli "teorici", ed in questo senso vanno intesi i pochi appunti

seguenti.

Schematizzando al massimo, vi possono essere due modi diversi di impostare il problema, ossia, estremizzando le posizioni: (1) nasciamo già "sapendo", già possediamo il linguaggio ed "imparare" vuole solo dire esercitare e portare alla coscienza; (2) alla nascita "non sappiamo" ancora nulla, non possediamo già il linguaggio, e siamo una tabula rasa che dobbiamo riempire inparando dall'esperienza.

La polarità di questo dibattito tra innatismo

ed empirismo, al di là dell'aspetto specifico del linguaggio, è ben noto

si può dire da sempre nella filosofia occidentale. La prima formulazione esplicita

dell'innatismo risale a Platone (427-347 a.C.; cfr. soprattutto i dialoghi

Fedro,

Fedone e

Menone,

dei quali non v'è un e-text in italiano, ma si può liberamente scaricare almeno la

versione inglese dal Project Gutenberg), con la

sua concezione delle idee innate, che l'uomo non deve fare altro che "ricordare";

le prime critiche, invece, ad Aristotele, con la sua rivalutazione dell'esperienza come

fonte di conoscenza.

È tuttavia alla fine del Seicento che si assiste

ad una migliore definizione, in senso moderno, del problema: da un lato abbiamo la

radicale confutazione, su base empiristica, dell'innatismo da parte dell'inglese John

Locke

(1632-1704) nel primo libro de An Essay Concerning Human Understanding, con

argomentazioni che riteniamo ancora oggi valide e conclusive; dall'altro

lato abbiamo la riaffermazione idealistica su base razionalistica (la "mente" fa

le veci delle "idee" di Platone ed è distinta dal "corpo" fisico), dell'innatismo da parte

di Cartesio

(cfr. anche Descartes' Epistemology),

o meglio René Descartes (1596-1650).

È soprattutto nella psicologia del Novecento, tuttavia, che

il dibattito delineato nel paragrafo precedente ha trovato espressioni che sono

state spesso trasportate anche nella teoria e nella pratica della linguistica.

Un valoroso tentativo di fondare la psicologia su basi empiriste è il

comportamentismo

(o behaviourismo), una teoria psicologica fondata dall'americano John Broadus Watson

(1878-1958) nel 1913 (con l'articolo Psychology as a Behaviorist Views It,

in " Psychological Review" XX (1913) 158-77), e sostenuta poi in termini più radicali

da Burrhus Frederik Skinner (1904-90). Incidentalmente, visto che il comportamentismo

ha ispirato molti programmi glottodidattici (fino grosso modo agli anni

Settanta) che oggi si concorda nel ritenere superati e meno efficaci di altri,

in molti manuali di glottodidattica circola un ritratto perlomeno ingeneroso

del behaviourismo e soprattutto del povero Skinner che, ad onta del parziale fallimento

dei programmi didattici a lui ispirati, fu uno studioso di irreprensibile livello

scientifico.

Il postulato fondamentale, d'altra parte, del behaviourismo è solo che

(1) la psicologia studia il comportamento e non la mente, e che

(2) le fonti del comportamento sono esterne, nell'ambiente,

e non interne, nella mente. Nelle sue formulazioni più radicali (e non condivisibili),

viene tuttavia anche sostenuta la posizione che (3) non

esiste (e non solo che non è direttamente studiabile) altra attività mentale

al di fuori dei comportamenti.

Come che sia, in questo quadro teorico

il comportamento può essere spiegato senza fare riferimento ad eventi mentali interni:

empiristicamente, dunque, si vuole limitare il ricorso della psicologia ai soli dati

osservabili (il che è scientificamente opportuno), ed eliminare il problema del dualismo tra

"mente" e "corpo" introdotto da Cartesio "riducendo" (il che è meno opportuno) la mente

al comportamento. Siamo, in ultima analisi, di fronte ad un tentativo di riduzione

del mentale analogo, come strategia, ma ben diverso nella sostanza, a quello che

compieranno i filosofi mentalisti (come Chomsky) "naturalizzatori": gli uni riducono

gli stati mentali a comportamenti (cioè alle loro manifestazioni), gli altri direttamente

ad oggetti naturali. È, da questo punto di vista, significativo che il programma

behaviourista entri in crisi negli anni '60 proprio quando la grammatica generativa,

il cognitivismo ed il funzionalismo computazionale (cfr. poco oltre) prendono vigore: anzi,

se si volesse assegnare una data di morte questa dovrebbe essere il 1959, in cui viene

pubblicata una tranciante recensione, a mano del giovane Chomsky (Syntactic Structures

è di soli due anni prima) di Verbal Behaviour di Skinner (in "Language" XXXV (1959) 26-58).

Di vero decesso, però, non è forse il caso di parlare dato che una forma ammodernata,

molto più moderata (che tiene buono solo il punto 1, e

riformula il 2, del programma originario) di behaviourismo

è oggi risorto ed è una delle scuole psicologiche attualmente più influenti: il

neocomportamentismo.

Oltre al behaviourismo (su cui mi sono soffermato anche per

compensare le carenze della manualistica glottodidattica) un'altra teoria

meno radicale ma ugualmente "riduzionista" è il funzionalismo, in quanto

riduce gli stati mentali a stati funzionali anziché a comportamenti; e dire

"stati funzionali" vuole in generale dire 'stati non sempre riconducibili a motivazioni

empiriche dirette': le "funzioni" sono pertanto di solito più complesse, nella loro

origine e nel loro ruolo, dei semplici schemi "stimolo-risposta" del behaviourismo.

In realtà, si dovrebbe parlare di vari

tipi di funzionalismo,

dato che se ne sono date diverse forme nella storia del pensiero novecentesco. Almeno due

accezioni principali vanno considerate tra le molte.

Il "primo" funzionalismo, come potremmo chiamarlo, o "funzionalismo classico", è quello fondante, fortemente legato alla filosofia americana di fine Ottocento ed alla tradizione del pragmatismo. È stato principalmente espressa ne The principles of Psychology (1890) di William James e ne The New Psychology (1884) di John Dewey. Per riassumere drasticamente, potremmo dire che, in una prospettiva al contempo pragmatista ed evoluzionista, questa teoria sosteneva che le funzioni mentali sono attività globali e non scomponibili (ossia non interpretabili se non olisticamente: in realtà ogni attività di un organismo vivente è un processo globale e continuo), ossia "processi dinamici" di carattere strumentale utili all'adattamento.

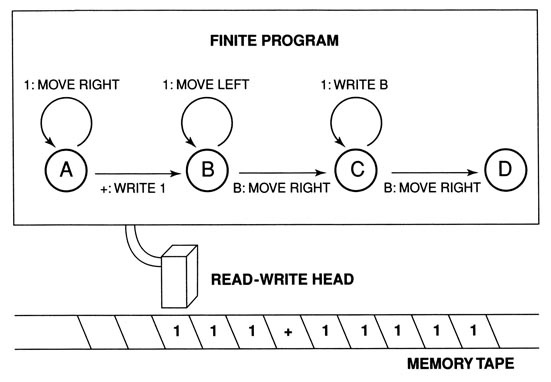

Accanto a questa prima varietà tardo-ottocentesca ed evoluzionista, l'altra forma importante di funzionalismo è quella del funzionalismo computazionale (o "funzionalismo da macchina di Turing") proposto negli anni '60-'70 del Novecento dal filosofo e matematico Hilary Whitehall Putnam (nato il 31 luglio 1926), una delle figure più importanti della filosofia analitica dei nostri giorni. In questa teoria le "funzioni" sono considerate, anziché delle reazioni adattive, come delle specie di programmi, la mente come una sorta di computer, (o meglio, come la sua forma più semplice: la "macchina di Turing") e gli uomini come sostanzialmente degli "automi probabilistici". La macchina di Turing è così chiamata dal matematico Alan Turing (1912-1954) che la propose nel 1936 diventando di fatto il padre dei computer moderni. La sua macchina, antenato dei nostri computer, è un semplice automa a stati finiti (cioè un sistema dinamico, invariante e discreto nell'avanzamento e nelle interazioni: per una definizione matematicamente più esatta cfr. questa pagina della Wikipedia).

«A Turing machine is an abstract representation of a computing device. It consists of a read/write head that scans a (possibly infinite) one-dimensional (bi-directional) tape divided into squares, each of which is inscribed with a 0 or 1. Computation begins with the machine, in a given "state", scanning a square. It erases what it finds there, prints a 0 or 1, moves to an adjacent square, and goes into a new state. This behavior is completely determined by three parameters: (1) the state the machine is in, (2) the number on the square it is scanning, and (3) a table of instructions. The table of instructions specifies, for each state and binary input, what the machine should write, which direction it should move in, and which state it should go into. (E.g., "If in State 1 scanning a 0: print 1, move left, and go into State 3".) The table can list only finitely many states, each of which becomes implicitly defined by the role it plays in the table of instructions. These states are often referred to as the "functional states" of the machine. A Turing machine, therefore, is more like a computer program (software) than a computer (hardware).»

[tav. 8a]

Schema di una macchina di Turing elementare, in assetto di calcolare un addizione

(i numerali sono in rappresentazione unale anziché decimale). Da Oron Shangrir,

The Rise and Fall of Computational Functionalism, in Hilary Putnam,

edited by Yemima Ben-Menahem, Cambridge (UK) - New York (USA), Cambridge University

Press, 2005 "Contemporary Philosophy in Focus", pp. 220-250, tav. a p. 223.

[tav. 8b]

Cos'è in breve una "macchina di Turing" secondo la Stanford Encyclopedia of Philosophy.

In sostanza, ben sintetizza le posizioni di questo indirizzo Oron Shangrir

(citato in Tav. 5a, cui rinvio per approfondimanti): «Computational functionalism

is the view that mental states and events - pains, beliefs, desires, thoughts and so forth -

are computational states of the brain, and so are defined in terms of "computational

parameters plus relations to biologically characterized inputs and outpus" (H. Putnam,

Representation and Reality, Cambridge (Mass.), MIT Press, 1988, p. 7). The

nature of the mind is indipendent of the physical making of the brain: "we could be

made of Swiss cheese and it wouldn't matter" (H. Putnam, Philosophy and our mental

life, p. 291, in Idem, Mind, Language and Reality. Philosophical Papers II,

Cambridge (UK), Cambridge University Press, 1975, pp. 291-303). What matters is our

functional organization: the way in which mental states are causally related to each

other, to sensory inputs and to motor outputs» (Shangrir 2005 cit., pp. 200-221).

Putnam, in realtà (seguo nell'esposizione ancora Shangrir 2005 cit.) sviluppa la sua

teoria in due fasi. Nei primi scritti si limita a proporre l'analogia tra menti e

macchine per far vedere che «the various issues and puzzles that make up the traditional

mind-body problem are wholly linguistic and logical in character ... all of the issues

arise in connection with any computing system capable of answering questions about

its own structure» (H. Putnam, Minds and Machines, in Dimensions of Mind,

edited by S. Hook, New York, University of New York Press, 1960, pp. 148-180; poi in

H. Putnam, Mind, Language and Reality. Philosophical Papers II, Cambridge (UK),

Cambridge University Press, 1975, pp. 362-385, citazione da p. 362). È solo negli scritti

successivi che Putnam mette in campo una vera teoria sulla natura degli stati mentali ed

identificandoli con gli stati funzionali: «to know for certain that a human being has

a particular belief, or preference, or whatever, involves knowing something about

the functional organization of the human being» (H. Putnam The Mental Life of Some Machines,

in Intentionality, Mind and Peception, edited by Hector-Neri Castañeda, Detroit,

Wayne State University Press, 1967, pp. 177-200; poi nei cit. Philosophical Papers II,

1975, pp. 408-428, citazione a p. 424); è persino ipotizzabile «that pain,

or the state of being in pain, is a functional state of a whole organism» (H. Putnam,

Psychological Predicates, in Art, Mind and Religion, edited by W. H.

Captain e D. D. Merrill, Pittsburgh, University of Pittsburgh Press, 1967, pp. 37-48;

poi col titolo Tge Nature of Mental States, con cui è di solito noto, nei

Philosophical Papers II cit., 1975, pp. 429-440, citazione a p. 433).

Il funzionalismo computazionale, va infine detto, ha avuto molto successo fino agli anni

Settanta ed Ottanta, ma è oggi considerato abbastanza superato, e Putnam stesso

negli anni Novanta se ne è esplicitamente distaccato.

I tentativi, in effetti, anche se da un certo punto di vista nobili, del behaviourismo e del funzionalismo, non risolvono certo tutti i problemi, ad esempio il primo non rende conto degli stati mentali non accompagnati da comportamento, ed il secondo tanto degli stati mentali soggettivi e privati quanto degli stati intenzionali come le credenze ed i desideri. Entrambi questi punti sono stati dimostrati dal filosofo John Searle con il famoso "esperimento mentale della Camera Cinese" (J. Searl, Minds, Brains and Programs, in "Behavioural and Brain Sciences" III (1980) 417-457 e The Chinese Room Revisited, ibidem V (1982) 345-348), indirizzato, in realtà, soprattutto contro il "funzionalismo da macchina di Turing".

«Immaginate di essere chiusi a chiave in una stanza che ha due finestre; attraverso una delle due finestre vi passano un fascio di fogli con dei segni che sembrano scrittura. Si trattano in effetti di ideogrammi cinesi, ma voi non sapete il cinese: per voi sono solo dei ghirigori senza senso. Ma vi vengono anche passate delle istruzioni (scritte in italiano, che voi conoscete) che vi dicono come fare corrispondere i segni che entrano dalla prima finestra a degli altri segni, per voi non meno incomprensibili, che vi si chiede di far passare attraverso l'altra finestra. Dopo un po', diventate abilissimi a seguire le istruzioni, sicché la messa in corrispondenza dei segni si svolge molto velocemente; ma ancora non capite che cosa sta succedendo. Ora, si scopre che la prima serie di segni erano domande (in cinese), e le istruzioni vi insegnavano a far loro corrispondere le risposte pertinenti (erano i segni che facevate passare dalla seconda finestra). Non sapevate il cinese prima, e continuate a non saperlo ora nonostante l'abilità che avete acquisito nel far corrispondere le due serie di segni; siete certamente in grado di manipolare i segni molto rapidamente seguendo le istruzioni che avete ricevuto, ma ancora non li comprendete. Ora, secondo Searle un computer su cui è implementato un sistema di comprensione del linguaggio naturale è esattamente nelle vostre condizioni: è in grado di manipolare simboli (che identifica in base alla loro forma) secondo regole tanto da emulare una seduta di domande e risposte, o qualsiasi altra prestazione linguistica; ma non capisce i simboli che manipola più di quanto voi, chiuso nella stanza, comprendiate il cinese.»

[tav. 9]

Un chiaro ma succinto resoconto in italiano dell'esperimento mentale della camera

cinese di Searle è quello fatto da Diego Marconi in La competenza lessicale,

Roma - Bari, Laterza, 1999, pp. 161-2, da cui è tratta la citazione in tav. 6.

Al di là, in effetti, del confutare singoli aspetti del comportamentismo e del funzionalismo (un osservatore esterno crederebbe che voi comprendiate il cinese, allo stesso modo - ricordate? - che nell'esperimento mentale [g] di Wittgenstein della partita di scacchi solo apparente che avevamo visto nel § 1.1.6), l'esperimento mentale di Searle mira proprio a mettere in discussione l'idea generale che la nostra mente funzioni come una sorta di computer (o di "macchina di Turing"): processamento di operazioni e loro comprensione in questo esperimento sembrano infatti cose distinte.

[tav. 10]

La convinzione che intelligenza artificiale ed intelligenza umana siano in qualche misura

costituzionalmente diverse riflette anche una opinione (fondata od infondata che sia)

abbastanza diffusa a livello di comune sentire: che in fin dei conti è proprio

quello espresso da Garfield in questa spiritosa striscia. Riprodotto da Jim Davis,

Garfield rounds out, New York, Ballantines Books, 1988.

Ad ogni buon conto, pur tra singoli problemi, il panorama della scena filosofica

e psicologica fino all'inizio degli anni Sessanta del Novecento, era dunque

sostanzialmente dominato da teorie di tipo empiristico, per cui tutti gli stati mentali

sono determinati dall'esterno da fatti del mondo, apprendimento del linguaggio compreso.

A spezzare il fronte è stato nel 1957 Noam Chomsky (di cui già abbiamo parlato) con la

linguistica generativa, cui presto si alleeranno il cognitivismo in psicologia,

("nato" nel 1967 con un lavoro di U. Neissert), la filosofia e le altre scienze cognitive,

cui pure abbiamo già accennato.

Avendendo visto nel § 1.4.3

la filiazione filosofica platonico-cartesiana dell' innatismo, è facile immaginare

come Chomsky non possa non posizionarsi su questa linea. Al di là delle sue preferenze

filosofiche, comunque, l'argomento principe che Chomsky usa è di tipo piuttosto

empirico che non teorico. Si tratta della facilità con cui un bambino impara uno strumento

complesso come il linguaggio in relativamente poco tempo ed in modo naturale e spontaneo

(l'adulto è limitato alla correzione sporadica, non interviene remunerando od allenando),

soprattutto paragonata alla difficoltà con cui un adulto impara una lingua straniera:

l'output (strutture linguistiche che il bimbo produce) sembra superare l'imput (stimolo

dato dalle persone che circondano il bimbo).

«La vecchia idea - per usare le parole di Paolo Casalegno, Filosofia del Linguaggio,

Roma, Carocci, 1998, p. 328 - che imparare a parlare voglia dire sviluppare un sistema di

disposizioni al comportamento verbale indotto da un qualche semplice meccanismo di

rinforzo è [...] vistosamente inadeguata». Bisogna pertanto, per Chomsky, ritornare, a

Platone ed ipotizzare che i bambini pervengono facilmente a parlare perché la conoscenza del

linguaggio è in larga misura innata. Chomsky, però, a differenza di Platone non

pensa alla teoria dell'anamnesi (imparare equivale a fare riaffiorare il ricordo di ciò

che l'anima ha dimenticato nascendo), quanto ad una fondazione biologica ed evoluzionistica

di tutte quelle facoltà, strutture e disposizioni che si possono intendere come l'organo,

geneticamente predeterminato, del linguaggio o facoltà del linguaggio (ricordate

che nelle nostre definizioni generali nel § 1.0.1

avevamo usato anche questa formulazione?).

Questo "organo" (a volte indicato come LAD "Language Acquisition Device") si sviluppa come

gli altri "organi" dell'uomo: si attiva solo in base all'esposizione a fattori esterni

(uso di una data lingua nell'ambiente circostante), cresce ed è pienamente funzionale

solo tra i quattro ed i dodici anni, poi si atrofizza. Chomsky, più esattamente, ha in

mente una struttura a principi (universali del linguaggio) e parametri (attivabili singolarmente

dalle singole lingue), che potrebbe dare conto tanto della diversità delle lingue

naturali (che in genere, però, il generativismo tende a sottostimare) quanto della

uniformità della Grammatica Universale (che, invece, il generativismo tende a esaltare):

non è però qui la sede per sostare diffusamente sullo schema "a principi e parametri",

dato che ci si sofferma adeguatamente già il manuale di Graffi e Scalise.

La teoria chomskiana ha senz'altro avuto il grande merito di gettare il sasso nello stagno, riportando all'attenzione il problema della mente (Chomsky, anzi, si richiama in modo esplicito e decisamente controcorrente proprio a Cartesio) collegandolo alla biologia evoluzionistica ed al dibattito filosofico contemporaneo. Non è però detto che debba rappresentare l'ultima parola, o che risolva tutti i problemi sul tappeto: nonostante la sua teoria presenti certo «difficoltà, Chomsky è un autore con il quale ci si deve cimentare per forza», per dirla con le parole del filosofo Paolo Casalegno in una delle più valide introduzioni recenti alla filosofia del linguaggio (Paolo Casalegno, Filosofia del linguaggio. Un'introduzione, Roma, Carocci, 1997; la cit. è da p. 327; si noti, tra l'altro, che pure nella prospettiva "filosofica" del volume un intero capitolo, il 12, è monograficamente dedicato a Chomsky. Tale capitolo, inoltre, costituisce una buona introduzione a Chomsky consigliabile a tutti, dato che limita al minimo il "tecnicismo" linguistico).

Un punto empiricamente debole della teoria chomskyana è

la questione dell'arresto completo dell'acquisizione linguistica

naturale intorno ai dodici anni: questa è, infatti, stata più volte messa in discussione,

anche se è in genere data per scontata dalla maggioranza dei linguisti contemporanei

(soprattutto dai glottodidatti). Naturalmente in anni di behaviourismo dominante si

riteneva (con pochi dati alla mano, in verità) il contrario (come esempio farò il nome

di un solo grande linguista americano, che si può considerare il padre della moderna

linguistica in America, Leonard Bloomfield, 1877-1949), ma per attendere una

falsificazione sperimentale oggettiva dobbiamo attendere tempi più recenti, ed in

particolare la maturazione della linguistica computazionale.

La linguistica computazionale, nata accanto allo sviluppo dell'informatica e dei

calcolatori, cresciuta a partire dagli anni Settanta ed ora in piena espansione, si

occupa del trattamento automatico e dell'analisi assistita dai calcolatori del

linguaggio naturale. I dati linguistici che analizza ed elabora sono di solito

costituite da corpora, ossia grandi collezioni di enunciati effettivamente

prodotti in una determinata lingua (che possono andare dai testi scritti, letterari o meno, alle registrazioni di

testi orali, siano esse conversazioni spontanee o meno), che vengono trattati in modo

da renderli utilizzabili dalle macchine. Sono, ossia, da un punto di vista chomskyano,

semplici raccolte di esecuzioni (di atti di "parole", diremmo noi, ed in ciò

teoricamente niente affatto diverse dai materiali che studiavano i linguisti-filologi prima

di Saussure e gli strutturalisti dopo): non stupirà, pertanto che Chomsky abbia

ripetutamente sostenuto che da un corpus il linguista non può imparare nulla. In ciò,

almeno in questo, sbagliandosi, come si può vedere da questo caso.

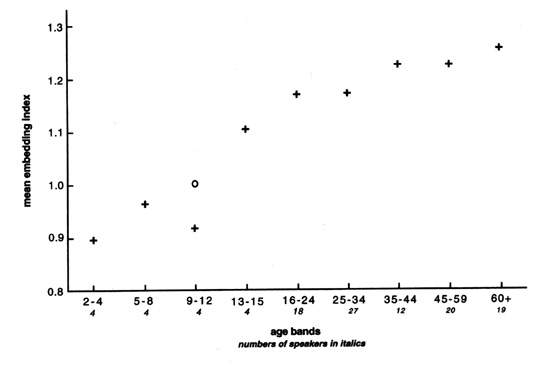

Da quando è stato messo a disposizione il British National Corpus o BNC,

si sono potuti avere dati controllabili scaglionati su fasce di età diverse di parlanti inglese, in base

ai quali Geoffrey Sampson ha potuto far vedere che l'uso di strutture sintattiche

incassate aumentava col progredire degli anni, confutando così che l'aquisizione

si arresti completamente a dodici anni:

[tav. 11]

Correlazioni demografiche della complessità sintattica (central embedding) in inglese

(BNC Corpus, subcorpus CHRISTINE). Riprodotto da Geoffrey Sampson, Empirical

Linguistics, London - New York, Continuum, 2001, p. 62

L'obiezione che i dati raccolti nel BNC siano solo "esecuzioni" e non

riguardino la "competenza" stenta a questo punto a convincerci (anzi, mostra la

debolezza intrinseca di un rifiuto generalizzato della "parole" come oggetto

d'indagine della linguistica), così come l'esperienza comune a tutti che imparare

una lingua da adulti è molto più difficile che non da bambini, non è necessariamente

una prova conclusiva (da bambini, ad esempio, correvamo e giocavamo tutto il giorno,

ora da adulti non reggeremmo una simile iperattività fisica neanche per poche ore,

anche se siamo naturalmente sempre in grado di correre, saltare, ecc.: entrambi i

fenomeni potrebbero rientrare nel normale sviluppo dell'invecchiamento).

Sulla base di considerazioni di questo tipo, Geoffrey Sampson, che è uno dei più

importanti linguisti computazionali britannici, ha proposto un programma, polemicamente

antigenerativista e che recupera alcune istanze (le migliori) del behaviourismo,

che ha chiamato Empirical Linguistics (cfr. Geoffrey Sampson, Educating

Eve. The "Language Instinct" debate, London - New York, Cassell, 1997 e Geoffrey Sampson,

Empirical Linguistics, London - New York, Continuum, 2001).

Ma a fare intravedere soluzioni parzialmente diverse, e più "empiriche",

di quella del generativismo ortodosso, sono anche le reti neurali,

sviluppate nel corso degli ultimi vent'anni in ambito dell'

intelligenza artificiale.

Una rete neurale, semplificando all'osso, è una simulazione informatica

di un circuito cerebrale: consiste in una rete di nodi-neuroni connessi ad altri nodi,

con delle connessioni-sinapsi che hanno un determinato "peso sinaptico" con valori da 1

(eccitazioni) a -1 (inibizioni); la rete può imparare, in quanto il peso sinaptico delle connessioni

può variare in base all'esperienza. Su queste basi, sono state progettate delle reti neurali

come modelli per simulare il processo della acquisizione linguistica.

L'esperienza più

significativa è stata la rete sviluppata da David Rummelhart e Jay McClelland

nel 1986 per l'apprendimento dei tempi passati dei verbi, poi espansa dallo stesso McClelland

e Mark Sedemberg nel 1989 per un apprendimento più generale del linguaggio. «The input

of the network - riporto la efficace descrizione di Richard F. Thompson,

The brain. A Neuroscience Primer, 3rd edition, New York, Worth Publishers,

2000, pp. 455-456 - was simply verbs and their past tenses. The rules for forming past tenses

were not put into the network; instead it had to learn these rules by example. The

investigators fed verbs and their past tenses into the network in proportion to their

frequency of use in English. A key issue was how the networks learned to form correct

past tenses of regular and irregular verbs. The astonishing result was that the

network seemed to learn the past tenses of verbs much as young children do. It learned

the general rules for forming regular past tenses before it learned to form the past tenses

of irregular verbs correctly. Thus, during the learning process it formed regular

past tenses for irregular verbs, for example, "digged" rather than "dug" This result

had profound implications for the nature of language. The network had no deep grammatical

structure built into it. Rather, it learned the abstract rules for forming past tenses

strictly from example; it learned the rules by "inference". If a simple neural network

with a few hundred units can learn this way, so can the vastly complex human brain.

Perhaps there is no deep language structure built into the brain». Esperimenti

con reti neurali anche in vivo (cfr. le esperienze con i molluschi Aplysia

condotte da Daniel Gardner cui accenneremo nel § 1.5.3)

sono tutt'ora in pieno sviluppo, e sono da aspettarsi risultati molto importanti.

Certo, se le reti neurali artificiali costituiscono un campo di ricerca in grande sviluppo,

anche per le numerose applicazioni pratiche che se ne possono fare (cfr. ad esempio

l'istruttiva pagina del Gruppo reti neurali

dell'Istituto nazionale di fisica nucleare), va però detto che lo studio delle reti neurali in vivo

procede più lentamente, forse a causa dell'enorme numero di competenze in campi diversi

richieste (matematica, matematica, biologia, fisica, chimica, logica, informatica ...);

su sviluppi recenti (o non fosse che per misurare il grado di difficoltà della

disciplina) si può consultare The Neurobiology of Neural Network, edited by

Daniel Gardner, Cambridge (Massachusetts) - London (England), MIT Press, 1993.